Voici la deuxième et dernière partie de notre série de blogues sur l’équité algorithmique. Dans la première partie, nous avons présenté l’équité algorithmique et analysé ses trois définitions principales. Dans cette deuxième partie, nous allons approfondir notre analyse en nous concentrant sur des sujets relevant plus précisément de sa mise en œuvre. Tout au long de cette discussion, nous partons du principe que les lecteurs disposent de connaissances techniques opérationnelles de l’intelligence artificielle (IA) et de l’apprentissage automatique (AA).

Présentation

D’un point de vue conceptuel, l’équité algorithmique est plutôt simple. Elle représente l’application du concept éthique de l’équité au domaine de l’IA/AA. Cette combinaison a entraîné la création d’une nouvelle discipline, dont l’objectif principal est de déterminer les conditions dans lesquelles on peut dire qu’un modèle d’IA/AA traite les personnes égales de manière égale, et les personnes inégales de manière inégale.

Toutefois, en pratique, l’équité algorithmique peut être difficile à mettre en œuvre. Non seulement il existe de nombreuses définitions incompatibles parmi lesquelles choisir, mais chacune interprète l’équité différemment, ce qui soulève certains avantages et inconvénients pour chacune d’entre elles. Même si l’équité algorithmique repose sur une base théorique solide, de nombreuses questions subsistent quant à la mise en pratique de ses notions.

Heureusement, un nombre croissant de recherches ont été consacrées à l’exploration de ce sujet complexe. L’aspect pratique de l’équité algorithmique peut être envisagé sous deux angles. D’une part, il y a le côté « positif », qui se concentre sur des mesures concrètes d’amélioration de l’équité et sur les techniques de « neutralisation des biais » qui peuvent être appliquées à un modèle d’IA/AA pour atteindre l’équité algorithmique. D’autre part, le côté plus « critique » tente de découvrir les limites inhérentes aux notions mathématiques de l’équité. Bien sûr, une telle distinction est relativement artificielle. Dans la pratique, les aspects « positifs » et « critiques » de l’équité algorithmique contribuent au même objectif sous-jacent, c’est-à-dire se rapprocher de la vérité, en ce qui concerne ses possibilités et ses limites.

Dans cette deuxième et dernière partie de notre série de blogues, nous conclurons notre analyse de l’équité algorithmique en explorant ces aspects pratiques supplémentaires. Nous aimerions préciser que le présent document n’est pas un guide pour l’application de l’équité algorithmique d’après les lois fédérales sur la protection des renseignements personnels. L’objectif de cette deuxième partie est de présenter les différentes mesures et limites de l’équité algorithmique afin de contextualiser notre compréhension de cette notion d’un point de vue technique, plutôt que juridique ou politique.

Quelles mesures peuvent être appliquées pour atteindre l’équité algorithmique?

Selon la définition d’équité algorithmique la plus appropriée pour la situation, différentes mesures techniques peuvent être appliquées au modèle d’IA/AA pour aider à satisfaire aux critères. Toutes les mesures ne relèvent pas exclusivement d’une définition en particulier. En fait, beaucoup d’entre elles sont transversales et fonctionnent aussi bien pour soutenir une définition ou une autre et dans différents contextes. Bien entendu, la façon d’appliquer chaque mesure dépendra du contexte de traitement des données.

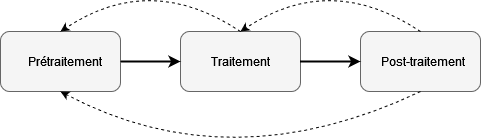

Dans les paragraphes ci-dessous, nous examinerons diverses mesures d’amélioration de l’équité en fonction des étapes du cycle de vie d’apprentissage propres à l’IA/AA. Tous les modèles d’IA/AA passent par un processus d’apprentissage. C’est au cours des différentes étapes du cycle de vie d’apprentissage que les mesures d’amélioration de l’équité ont l’incidence la plus directe. De manière générale, ce cycle de vie comporte trois étapes : prétraitement, traitement et post-traitement. Chaque étape comprend un ensemble de mesures à considérer.

Bien qu’elles soient organisées de manière chronologique, les étapes forment dans la pratique un processus itératif, où chaque étape influe sur les autres et peut être revisitée à tout moment en fonction des résultats du processus.

Prétraitement

À cette étape préliminaire, l’accent est mis sur les données d’apprentissage elles-mêmes. Comme l’IA/AA fonctionnent en cherchant à adapter le mieux possible un modèle mathématique à un ensemble de données d’apprentissage, plus les données d’apprentissage traduisent fidèlement l’objet ou le résultat à prévoir, plus le modèle a de chances d’apprendre et de mettre en œuvre par défaut une représentation équitable du comportement passé des individus. Par conséquent, les mesures associées à cette étape consistent à modifier ou à augmenter les données d’apprentissage pour permettre au modèle d’IA/AA de respecter l’équité. Il existe en fait trois priorités :

- S’assurer que les données d’apprentissage sont équilibrées et représentatives de la population. L’IA/AA apprennent grâce aux exemples. Donc, l’IA/AA sont incapables de comprendre ce qui ne leur a pas déjà été montré. Si les données utilisées pour l’apprentissage d’un modèle d’IA/AA sous-représentent ou ne contiennent pas assez d’exemples de certains groupes qui font partie de la population à laquelle le modèle d’IA/AA sera appliqué, alors le modèle ignorera ou négligera les relations statistiques qui prédisent la variable cible pour eux. Si ces relations diffèrent de celles des autres groupes surreprésentés, des disparités considérables peuvent apparaître sur le plan de la performance. Par exemple, des études ont montré que certains outils d’analyse faciale pour l’estimation du genre présentent des taux d’erreur disproportionnés (en anglais seulement) dans les groupes définis par la race et le genreNote de bas de page 1.

- S’assurer que la réalité du terrain est objective. Dans un ensemble de données d’apprentissage, la réalité du terrain, ou variable cible, représente ce qui est considéré comme une réponse correcte à une prédiction sur la foi des valeurs des caractéristiques présentes à ses côtés. Cependant, ce n’est pas parce qu’une variable porte le nom de « réalité du terrain » qu’elle l’est nécessairement. Dans le domaine du comportement humain en particulier, il est parfois difficile, voire impossible, d’obtenir des données objectives de haute qualité concernant les étiquettes pour l’apprentissage supervisé. Dans de tels cas, il peut être tentant de remplacer une représentation complète et précise de l’objet ou du résultat à prédire par un substitut plus facile à obtenir, mais moins fiable en tant qu’indicateur. Si la variable de substitution est trop subjective ou dépend de la discrétion humaine pour remplir son rôle, il se pourrait qu’elle contienne des biais historiques ou d’autres éléments qui seraient appris et, éventuellement, reproduits dans le modèle d’IA/AA. Par exemple, les outils d’évaluation du risque de récidive ont été critiqués pour leur utilisation dans des arrestations documentées en tant qu’indicateur de la criminalité réelleNote de bas de page 2 (en anglais seulement).

- S’assurer que les caractéristiques prédisent la variable cible de manière égale dans tous les groupes. De même, toutes les caractéristiques d’un ensemble de données d’apprentissage peuvent ne pas avoir le même niveau d’importance statistique en termes de prédiction de la variable cible dans tous les groupes. Pour certains groupes, la présence ou l’absence d’une caractéristique particulière peut être un indicateur fiable de la variable cible, alors que pour d’autres, elle peut l’être dans une moindre mesure, voire ne pas l’être du tout. Si les caractéristiques ne prédisent pas la variable cible de la même manière pour tous les groupes, cela peut conduire à une situation biaisée, où le modèle d’IA/AA surestime la variable cible pour les groupes dont les caractéristiques la prédisent moins et sous-estime la variable cible pour les groupes dont les caractéristiques la prédisent plus. Dans de tels cas, des solutions inédites peuvent être nécessaires. Par exemple, certaines administrations ont mis en place des outils d’évaluation du risque de récidive propre au genre (en anglais seulement) pour répondre aux préoccupations liées aux préjugésNote de bas de page 3.

Traitement

Après la préparation des données d’apprentissage, l’étape suivante consiste à entreprendre le processus réel d’apprentissage du modèle d’IA/AA. L’accent est donc mis sur l’algorithme d’apprentissage. Étant donné que le processus d’apprentissage en l’IA/AA consiste à essayer de réduire au minimum la valeur d’une fonction de coût, plus la fonction elle-même est assortie de critères pénalisant l’iniquité, plus le processus lui-même a de chances de générer un modèle assorti de relations statistiques équitables. Par conséquent, les mesures associées à cette étape consistent à imposer des contraintes à la fonction de coût ou à l’algorithme d’apprentissage afin de mieux rendre compte de l’équité dans la formation de relations statistiques. De manière générale, il y a deux mesures à prendre en compte :

- Ajouter une ou plusieurs modalités de régularisation améliorant l’équité à la fonction de coût. La fonction de coût d’un modèle d’IA/AA représente l’état général dont le modèle doit s’éloigner pour améliorer son rendement, c’est-à-dire pour devenir plus « intelligent ». En plus de pénaliser les erreurs de prédiction et le surajustement, il est possible d’inclure des modalités pénalisantes pour réduire au minimum les manifestations d’injustice. À titre d’exemple, certains chercheurs ont suggéré l’utilisation d’un « suppresseur de préjugés » en tant que modalité de régularisation afin de pénaliser la quantité d’information mutuelle entre les notes du classifieurs et les attributs sensiblesNote de bas de page 4 (en anglais seulement).

- Utiliser l’apprentissage contradictoire équitable. Des recherches récentes en IA/AA ont conduit à l’élaboration d’une nouvelle méthode d’apprentissage, où la fonction de coût est représentée par un jeu compétitif entre deux modèlesNote de bas de page 5 (en anglais seulement). L’un des modèles, communément appelé « générateur », tente de produire des exemples qui déjouent l’autre modèle, communément appelé « discriminateur », qui tente à son tour de deviner si les exemples ont une certaine propriété ou non. Les deux modèles sont liés par une boucle de rétroaction qui leur permet d’améliorer leurs capacités. Enfin, si les modèles ont une capacité suffisante, l’apprentissage atteint un point d’équilibre où le discriminateur ne peut pas distinguer les exemples avec la propriété de ceux sans la propriété, parce que le générateur a appris à les « occulter ».

Lorsqu’il est utilisé pour l’équité, le générateur est le classifieur. La propriété que le discriminateur cherche à deviner et que le générateur essaie d’occulter est l’attribut sensible. Dans les faits, cela transforme le processus d’apprentissage en un problème d’optimisation, où l’objectif consiste à rendre le classifieur le mieux en mesure de prédire la variable cible tout en réduisant au minimum la capacité du discriminateur à prédire l’attribut sensibleNote de bas de page 6 (en anglais seulement).

Post-traitement

Après l’apprentissage, la dernière étape consiste à définir un seuil approprié. Étant donné que les tâches de classement en IA/AA fonctionnent souvent en tant que tâches de régression, mais avec un point de démarcation définissant les limites de la catégorie, l’endroit où le seuil est fixé a d’importantes répercussions en matière d’équité. Des valeurs de seuil différentes modifieront généralement la proportion relative de membres correctement et incorrectement attribués à la classe positive et négative dans les différents groupes, affectant ainsi les valeurs prédictives respectives, les taux d’erreur et la proportion totale de résultats positifs. Par conséquent, les mesures associées à cette étape consistent à fixer ou à modifier le seuil de notation pour que les prédictions du modèle d’IA/AA répondent à certains critères d’équité. En général, il y a deux mesures dont il faut tenir compte :

- Définir le seuil à une valeur qui satisfait à votre critère d’équité. Cette mesure découle directement du concept de seuil. Comme indiqué ci-dessus, différentes valeurs de seuil modifieront généralement la proportion relative de membres correctement ou incorrectement attribués à la classe positive et négative dans les différents groupes. Si le seuil est fixé à un point de démarcation où les valeurs prédictives, les taux d’erreur ou la proportion totale de résultats positifs sont égaux entre les groupes, alors certains critères d’équité seront satisfaits. On y parvient souvent en localisant le point, si possible, au croisement des courbes d’un graphique. Par exemple, la courbe de fonction d’efficacité de l’observateur représente le taux de vrais positifs par rapport au taux de faux positifs pour différents seuils d’un classifieur binaire. Le point d’intersection des courbes propres au groupe représente une parité des taux d’erreur, ce qui respecte la séparation.

- Utiliser un seuil distinct pour chacun des groupes. Cette mesure est essentiellement une version extrême de la précédente. Au lieu d’un seuil unique pour définir les limites des catégories dans tous les groupes, un seuil distinct peut être défini pour chaque groupe et fixé à un point de démarcation qui satisfait individuellement à certains critères d’équité partagés. Par exemple, en réponse à la première formulation de Cleary sur la suffisance, certains chercheurs ont plaidé pour une plus grande souplesse dans la détermination des résultats pour les groupes ayant obtenu les notes les plus basses et ont suggéré l’utilisation de multiples seuils pour obtenir une proportion plus équilibrée de résultatsNote de bas de page 7 (en anglais seulement). Toutefois, cette mesure a également été critiquée pour avoir transféré à l’utilisateur final la responsabilité du concepteur. Par exemple, dans une étude qu’il a réalisée sur les effets démographiques des algorithmes de reconnaissance faciale, le National Institute for Standards and Technology des États-Unis « écarte » l’idée de seuils propres à un groupe, car ils exigent que le propriétaire du système détermine les différents niveaux de seuil par l’intermédiaire d’une forme de test appropriée (en anglais seulement) puis de créer un logiciel supplémentaire pour mettre en œuvre cette stratégieNote de bas de page 8.

Quelles sont les limites des notions mathématiques de l’équité?

L’équité algorithmique partage les propriétés de base de l’équité, mais elle se différencie également du concept éthique de l’équité en se concentrant sur le traitement des individus et des groupes dans le contexte d’un modèle d’IA/AA. L’IA/AA sont des technologies mathématiques modernes, dont la perspective est fondamentalement différente de celle de l’éthique et de l’équité. Comme indiqué dans les paragraphes d’introduction de la première partie de cette série de blogues, l’équité se caractérise par une ambiguïté orientée vers le futur, alors que l’IA/AA présentent une exactitude de type « ce qui est passé n’est que prologue ». Si ces deux disciplines peuvent être fusionnées dans une certaine mesure, en fin de compte, leurs différences ne peuvent pas être entièrement résolues.

Une conséquence de ce problème insoluble est que l’équité algorithmique ne peut que servir à estimer l’équité. Vu sa nature mathématique et la priorité qu’elle accorde au calcul au détriment de la délibération, l’équité algorithmique n’a pas le discernement nécessaire pour évaluer une situation dans le temps et en fonction du contexte afin de déterminer les éléments éthiques de l’équité. Aussi, son utilisation s’accompagne d’importantes limites et mises en garde concernant la validité de ses résultats. De manière générale, quatre sont dignes de mention :

- Elle n’aborde pas les conséquences éthiques de la tâche réellement effectuée par un modèle d’IA/AA. L’équité algorithmique fonctionne en comparant le comportement d’un modèle d’IA/AA dans différents groupes par rapport à un certain nombre de critères. Sur la foi des résultats de cette comparaison, le modèle d’IA/AA est jugé équitable ou non. Cependant, lorsqu’il s’agit des conséquences éthiques de la tâche réellement effectuée par le modèle d’IA/AA, l’équité algorithmique ne se prononce pas. Elle n’évalue pas la moralité ou l’éthique sous-jacente de la tâche elle-même, mais uniquement les caractéristiques observées de son application après coup. Ce problème éthique peut conduire à des situations paradoxales, où une tâche automatisée manifestement contraire à l’éthique peut être considérée comme algorithmiquement « juste ». Par exemple, un groupe d’universitaires a écrit un texte satirique fictif (en anglais seulement) montrant comment un système algorithmique conçu pour transformer les personnes âgées en nutriments peut néanmoins respecter le cadre de l’équité, de la responsabilité et de la transparenceNote de bas de page 9. Un exemple réel et actuel est la façon dont certaines entreprises de médias sociaux conçoivent leurs algorithmes de fil d’actualité pour augmenter au maximum la participation des utilisateurs sur la base des taux de clics (en anglais seulement). Ce faisant, elles donnent indirectement la priorité à des articles d’information (ou de désinformation) conçus particulièrement pour exploiter la colère, la peur et le ressentiment des gens et exercent donc une influence indue.

- Elle ne peut déterminer quelle définition est appropriée ou « juste » dans les circonstances. L’équité algorithmique consiste en de multiples définitions qui sont généralement incompatibles. Il importe donc de se demander quelle définition est appropriée, et dans quelles circonstances. Quelle définition parmi la suffisance, la séparation et l’indépendance devrait être considérée comme « juste »? Les outils de l’équité algorithmique ne peuvent pas répondre à cette question. Ils permettent seulement de déterminer si un critère en particulier est satisfait, et non s’il devrait l’être. Aristote avait une façon intéressante de décrire cette limite de la pensée technique. Il a fait une distinction entre le mode de pensée de la « technologie » (ou « le savoir-faire »; techné) et celui de la « sagesse pratique » (phronésis). Alors que la technologie ne peut penser au-delà des produits dont elle cherche à optimiser l’utilité ou l’efficacité, la sagesse pratique est capable de percevoir les actions humaines qui permettent généralement de bien vivreNote de bas de page 10 (en anglais seulement). Par conséquent, seul un élément semblable à la sagesse pratique d’Aristote peut décider quel critère d’équité algorithmique est réellement juste dans les circonstances.

Il importe également de noter que cette limitation de l’équité algorithmique est en accord avec les conclusions de la jurisprudence actuelle en matière de droits de l’homme, en particulier au Canada. Par exemple, dans l’analyse des allégations de discrimination entraînant des effets néfastes, la Cour suprême du Canada a déclaré dans Fraser c. Canada qu’il « […] n’existe aucune mesure universelle permettant de déterminer le niveau de disparité statistique nécessaire pour démontrer qu’il y a un effet disproportionné, et la Cour ne devrait pas […] concevoir de règles rigides à cet égardNote de bas de page 11 ». Une analyse complète de l’équité juridique et des règles juridiques en matière de discrimination dépasse le cadre de cette série de blogues. - Ses résultats peuvent être manipulés. La question de savoir si un modèle d’IA/AA respecte une certaine définition de l’équité algorithmique dépend uniquement des relations statistiques entre trois variables : la réalité du terrain Y, la note prédite R et l’attribut sensible A. Cependant, les données utilisées pour alimenter ces variables sont souvent générées à partir d’observations de processus du monde réel qui sont contrôlés par la même organisation que celle dont l’utilisation ou la conception d’un modèle d’IA/AA est examiné. Or, cette situation ouvre la porte à d’éventuels abus ou manipulations. En modifiant la fréquence, le comportement, la portée ou la nature du processus, une organisation pourrait constituer un ensemble de valeurs variables qui semblent correspondre à une certaine définition de l’équité algorithmique, mais qui, en réalité, ne servent qu’à copier ses relations statistiques. Plusieurs études universitaires ont soulevé cet enjeuNote de bas de page 12 (en anglais seulement). Par exemple, une organisation pourrait réduire artificiellement le taux d’erreur de son programme de reconnaissance faciale en resoumettant intentionnellement des requêtes concernant des individus dont elle connaît déjà l’identité.

- Elle ne peut pas évaluer ses propres effets. L’équité algorithmique vise à promouvoir le mieux-être des individus ou des groupes en imposant un critère démographique général aux résultats d’un modèle d’IA/AA. Cependant, le fait que des individus ou des groupes bénéficient réellement d’une telle intervention dépend en définitive des effets des décisions sur leur vie à long terme. Si l’équité algorithmique peut se traduire par des avantages plus importants à court terme, des études indiquent que les critères d’équité communs ne favorisent pas nécessairement l’amélioration au fil du tempsNote de bas de page 13 (en anglais seulement). Par exemple, le fait d’exiger d’une banque qu’elle accorde des prêts à des personnes qui sont moins susceptibles de les rembourser finit par appauvrir les personnes qui finissent par ne pas les rembourser. Il s’agit d’un problème que l’équité algorithmique ne saurait résoudre à elle seule.

Conclusion

Dans cette deuxième et dernière partie de notre série de blogues sur l’équité algorithmique, nous avons approfondi notre analyse d’un point de vue pratique et obtenu de l’information supplémentaire sur la nature de l’équité algorithmique :

- Les mesures visant à favoriser l’équité algorithmique peuvent être organisées en trois groupes, en fonction des étapes du cycle de vie de l’apprentissage en IA/AA :

- Prétraitement

- S’assurer que les données d’entraînement sont équilibrées et représentatives de la population;

- S’assurer que la réalité du terrain est objective;

- S’assurer que les caractéristiques prédisent la variable cible de manière égale dans tous les groupes.

- Traitement

- Ajouter une ou plusieurs modalités de régularisation améliorant l’équité à la fonction de coût;

- Utiliser l’apprentissage contradictoire équitable.

- Post-traitement

- Définir le seuil à une valeur qui satisfait à votre critère d’équité;

- Utiliser un seuil distinct pour chacun des groupes.

- Prétraitement

- En raison de sa nature mathématique, l’équité algorithmique présente plusieurs limites éthiques :

- elle n’aborde pas les conséquences éthiques de la tâche réelle effectuée par un modèle d’IA/AA;

- elle ne peut déterminer quelle définition est appropriée ou « juste » dans les circonstances;

- ses résultats peuvent être manipulés;

- elle ne peut pas évaluer ses propres effets.

Sur la foi de ces renseignements supplémentaires, il apparaît clairement que l’équité algorithmique est non seulement une discipline complexe, mais qu’elle n’est pas une panacée. Bien que diverses mesures pratiques puissent être appliquées pour y parvenir, les notions mathématiques d’équité ont en définitive des limites éthiques inhérentes qui ne peuvent être abordées correctement qu’à l’aide d’une réflexion non technique. Comme toujours, lorsqu’il s’agit d’évaluer les utilisations éthiques de la technologie, la clé est de poursuivre le processus de délibération et de ne pas laisser les calculs remplacer la réflexion!